Lexoro Data Science Survey

Wir von lexoro möchten die Community mit informativen Beiträgen fördern und erstellen dazu regelmäßige Mini-Studien. Die aktuelle Umfrage finden Sie in diesen Artikel eingebettet (siehe unten) oder mit einem Klick auf diesen Direktlink.

Data Science…more than Python, TensorFlow & Neural Networks

Künstliche Intelligenz, Data Science, Machine Learning – das sind die Schlagwörter der Stunde. Man kann sich den Berichten und Artikeln über die technologischen Entwicklungen, Trends und die Veränderungen, die uns bevorstehen kaum entziehen. Viele sind sich einig: Wir stehen vor einem Paradigmenwechsel vorangetrieben durch einen technologischen Fortschritt, dessen Geschwindigkeit – auch wenn es vielen zu schnell geht – exponentiell zunimmt. Und auch wenn wir noch am Anfang dieses neuen Zeitalters stehen, so sind die Veränderungen jetzt schon zu spüren – in den Unternehmen, in unserem Alltag, in unserer Kommunikation…

Der Arbeitsmarkt im Speziellen sieht sich auch einem starken Veränderungsprozess unterworfen. Berufe, die noch vor nicht allzu langer Zeit als nicht durch Maschinen ersetzbar galten, sind dabei zu verschwinden oder zumindest sich zu verändern. Gleichzeitig entstehen neue Jobs, neue Rollen, neue Verantwortungsbereiche. Kaum ein Unternehmen kommt daran vorbei sich den Herausforderungen dieses technologischen Wandels zu stellen. Neue Strukturen, Abteilungen, Arbeitsmodelle und Jobs entstehen.

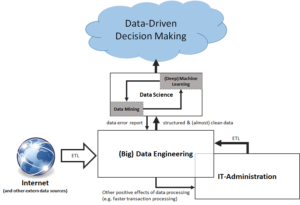

Doch um auf die anfangs genannten Hype-Begriffe zurückzukommen – was verbirgt sich eigentlich hinter Data Science, Machine Learning und Artificial Intelligence?! Was macht einen guten Data Scientist eigentlich aus?

Die Antwort scheint aus Sicht vieler Manager einfach: im Studium Python lernen, regelmäßig Big Data Tools von Hadoop nutzen, sich in TensorFlow einarbeiten und etwas über Neural Networks lesen – und fertig ist der Data Scientist. Doch so einfach ist es leider nicht. Oder eher zum Glück?! Neue Job-Rollen erfordern auch neue Denkweisen im Recruiting! Wir entfernen uns von einem strikten Rollen-basiertem Recruiting und fokussieren uns immer mehr auf die individuellen Kompetenzen und Stärken der einzelnen Personen. Wir sind davon überzeugt, dass die treibenden Köpfe hinter der bereits laufenden Datenrevolution deutlich facettenreicher und vielschichtiger sind als sich das so mancher vielleicht wünschen mag.

Diesem Facettenreichtum und dieser Vielschichtigkeit wollen wir auf den Grund gehen und dieser Survey soll einen Beitrag dazu leisten. Welche Kompetenzen sollte ein guter Data Scientist aus Ihrer Sicht mitbringen? In welchen Bereichen würden Sie persönlich sich gerne weiterentwickeln? Haben Sie die Möglichkeiten dazu? Sind Sie auf dem richtigen Weg sich zu einem Data Scientist oder Machine Learning Expert zu entwickeln? Oder suchen Sie nach einem ganz anderen Karriereweg?

Mit einem Zeit-Investment von nur 5 Minuten leisten Sie einen wertvollen Beitrag zur Entwicklung unseres A.I.-Skillprints, der es ermöglichen wird, eine automatische, datengestützte Analyse Ihrer A.I.-bezogenen Fähigkeiten durchzuführen und Empfehlungen für eine optimale Karriereentwicklung zu erhalten.

Vielen Dank im Voraus für Ihre Teilnahme!

Das lexoro-Team